概率论与数理统计-概率论-大数定律与中心极限定理

概率论与数理统计-大数定律与中心极限定理

本章介绍概率统计理论中非常重要的两类定理:大数定律和中心极限定理。

大数定律讨论的是一列随机变量的均值的收敛性问题。(独立、同期望、同方差的随机变量列\(\{X_n\}\)的算数平均依概率收敛于期望\(\mu\))

中心极限定理考虑的是一列随机变量和的极限分布问题。(独立、同分布的随机变量列\(\{X_n\}\)的和的分布近似为正态分布)

基本概念

依概率收敛

设\(X_{1}, X_{2}, \cdots\)为一随机变量序列,X为一随机变量, 若对任意\(\epsilon>0\),有\(\lim _{n \rightarrow \infty} P\left(\left|X_{n}-X\right| \geqslant \epsilon\right)=0\), 则称\(\{x_n\)}$依概率收敛于X.

切比雪夫不等式

切比雪夫不等式的提出

19世纪俄国数学家切比雪夫研究统计规律中,论证并用标准差表达了一个不等式,这个不等式具有普遍的意义,被称作切比雪夫定理,其大意是:

任意一个数据集中,位于其平均数m个标准差范围内的比例(或部分)总是至少为1-1/m2, 其中m为大于1的任意正数。对于m=2,m=3和m=5有如下结果:

- 所有数据中,至少有3/4(或75%)的数据位于平均数2个标准差范围内。

- 所有数据中,至少有8/9(或88.9%)的数据位于平均数3个标准差范围内。

- 所有数据中,至少有24/25(或96%)的数据位于平均数5个标准差范围内 。

换言之, 与平均相差k个标准差以上的值,数目不多于1/k^2

- 与平均相差2个标准差以上的值,数目不多于1/4

- 与平均相差3个标准差以上的值,数目不多于1/9

- 与平均相差5个标准差以上的值,数目不多于1/25

切比雪夫不等式的数学描述

说法一: 设随机变量X的数学期望为\(\mu\),方差为\(\sigma^2\), 则对于任意\(\epsilon>0\),有\(P(|X-\mu| \geqslant \epsilon) \leqslant \frac{\sigma^{2}}{\epsilon^{2}}\)

说法二: 设随机变量X的数学期望为\(\mu\),方差为\(\sigma^2\), 则对于任意\(\epsilon>0\),有\(P(|X-\mu|<\epsilon) \geqslant 1-\frac{\sigma^{2}}{\epsilon^{2}}\)

说法三:(取\(\epsilon=k \sigma\)) 设随机变量X的数学期望为\(\mu\),方差为\(\sigma^2\), 则\(P(\mu -k\sigma <X<\mu +k\sigma )\geq 1-{\frac {1}{k^{2}}}\)

证明: 以下仅证明X是连续型随机变量的情形(X是离散型随机变量类似): 设随机变量X的密度函数为\(f(x)\),则有 \(\begin{aligned} P(|X-\mu| \geqslant \epsilon) &=\int_{|x-\mu| \geqslant \epsilon} f(x) \mathrm{d} x \leqslant \int_{|x-\mu| \geqslant \epsilon} \frac{|x-\mu|^{2}}{\epsilon^{2}} f(x) \mathrm{d} x \\ & \leqslant \frac{1}{\epsilon^{2}} \int_{-\infty}^{+\infty}(x-\mu)^{2} f(x) \mathrm{d} x=\frac{\sigma^{2}}{\epsilon^{2}} \end{aligned}\)

大数定律

参考:https://zh.wikipedia.org/wiki/%E5%A4%A7%E6%95%B0%E5%AE%9A%E5%BE%8B 参考:https://baike.baidu.com/item/%E5%88%87%E6%AF%94%E9%9B%AA%E5%A4%AB%E5%A4%A7%E6%95%B0%E5%AE%9A%E5%BE%8B 参考: 参考:https://baike.baidu.com/item/%E8%BE%9B%E9%92%A6%E5%A4%A7%E6%95%B0%E5%AE%9A%E5%BE%8B 参考:https://zhuanlan.zhihu.com/p/77312635 参考:https://baike.baidu.com/item/%E5%BC%BA%E5%A4%A7%E6%95%B0%E5%AE%9A%E5%BE%8B

大数定律告诉我们能用频率近似代替概率;能用样本均值近似代替总体均值(算数平均值接近期望值)。 样本数量越多,则其算术平均值就有越高的概率接近期望值。

总结来看,大数定理将属于数理统计的平均值和属于概率论的期望联系在了一起。

大数定律还有强大数定律和弱大数定律之分,这里不做讨论.

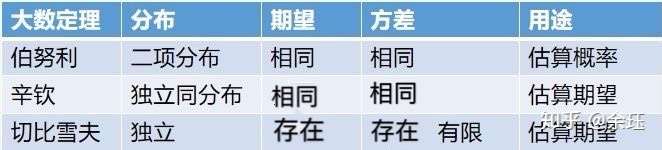

下面介绍大数定律的几个版本.

切比雪夫大数定律(切比雪夫定理):揭示样本均值和真实期望的关系

设随机变量序列 \(\left\{X_{i}\right\}\) 两两相对独立,且期望存在 \(E\left(X_{i}\right)=\mu_{i},\) 方差存在且有共同有限上界 \(D\left(X_{i}\right)=\sigma_{i}^{2}<M,\) 则对 \(\forall \varepsilon>0, \quad \lim _{n \rightarrow+\infty} P\left\{\left|\frac{1}{n} \sum_{i=1}^{n} X_{i}-\frac{1}{n} \sum_{i=1}^{n} \mu_{i}\right|<\varepsilon\right\}=1\)

切比雪夫大数定律的特殊情形

(设随机变量序列 \(\left\{X_{i}\right\}\) 两两相对独立的前提下) 特别的, 若 \(\left\{X_{i}\right\}\) 有相同的期望 \(\mu,\) 则有 \(\lim _{n \rightarrow+\infty} P\left\{\left|\frac{1}{n} \sum_{i=1}^{n} X_{i}-\mu\right|<\varepsilon\right\}=1\) 。

有另一种说法: 设\(X_1,X_2,\cdots\)是相互独立的随机变量(某些材料上是两两独立),且具有相同的数学期望\(\mu\)及相同的方差\(\sigma^2\), 则对任意\(\sigma>0\),有\(\lim _{n \rightarrow \infty} P\left(\left|\frac{1}{n} \sum_{i=1}^{n} X_{i}-\mu\right| \geqslant \epsilon\right)=0\). 即 \(\frac{1}{n} \sum_{i=1}^{n} X_{i}\) 依概率收敛于 \(\mu\).

证明 取随机变量\(X=\frac{1}{n} \sum_{i=1}^{n} X_{i}\) 由\(E\left[\frac{1}{n} \sum_{i=1}^{n} X_{i}\right]=\mu\), \(D\left[\frac{1}{n} \sum_{i=1}^{n} X_{i}\right]=\frac{\sigma^{2}}{n}\) 由切比雪夫不等式可得 \(P\left(\left|\frac{1}{n} \sum_{i=1}^{n} X_{i}-\mu\right| \geqslant \epsilon\right) \leqslant \frac{\sigma^{2}}{n \epsilon^{2}}\) 令\(n\rightarrow\infty\)即得 \(\lim _{n \rightarrow \infty} P\left(\left|\frac{1}{n} \sum_{i=1}^{n} X_{i}-\mu\right| \geqslant \epsilon\right)=0\)

在所给条件下(独立,同期望方差), n个随机变量\(X_1,X_2,\cdots,X_n\)的算数平均值\(\frac{1}{n} \sum_{i=1}^{n} X_{i}\)当\(n\rightarrow\infty\)时,与它们的共同期望\(\mu\)非常接近.

物理上,我们经常对某个物理量重复测量n次,并且利用n次测量值的算数平均作为该物理量真实值\(\mu\)的估计.n越大,所得均值越接近真实值\(\mu\).

将该公式应用于抽样调查,就会有如下结论:随着样本容量n的增加,样本平均数将接近于总体平均数。从而为统计推断中依据样本平均数估计总体平均数提供了理论依据。

特别需要注意的是,切比雪夫大数定理并未要求\(X_1,X_2,\cdots,X_n\)同分布,相较于伯努利大数定律和辛钦大数定律更具一般性。

伯努利大数定律:揭示概率与频率的关系

设事件A在一次试验中发生的概率为p (0<p<1), 将试验独立进行n次,用\(n_A\)表示事件A发生的次数, 则对任意\(\epsilon>0\),有\(\lim _{n \rightarrow \infty} P\left(\left|\frac{n_{A}}{n}-p\right| \geqslant \epsilon\right)=0\)

证明 构造一列随机变量\(X_1,X_2,\cdots,X_n\),如下: \(X_{i}=\left\{\begin{array}{ll}1, & A \text { 在第i次试验中发生, } \\ 0, & \text { A在第i次试验中不发生. }\end{array}\right.\) 于是\(\frac{n_{A}}{n}=\frac{1}{n} \sum_{i=1}^{n} X_{i}, \quad E\left(X_{i}\right)=p\) 根据切比雪夫大数定律的特殊情形, 可得\(\lim _{n \rightarrow \infty} P\left(\left|\frac{n_{A}}{n}-p\right| \geqslant \epsilon\right)=0\)

从定义概率的角度,揭示了概率与频率的关系,当N很大的时候,事件A发生的概率等于A发生的频率。

辛钦大数定律:揭示算术平均值和数学期望的关系

设一列随机变量\(X_1,X_2,\cdots,X_n\)相互独立,同分布,且有共同数学期望为\(\mu\),(同分布隐含了期望相同) 则对于任意\(\epsilon>0\),有\(\lim _{n \rightarrow \infty} P\left(\left|\frac{1}{n} \sum_{i=1}^{n} X_{i}-\mu\right| \geqslant \epsilon\right)=0\)

中心极限定理

通俗的讲,中心极限定理表述的是如下结论:在一定条件下,大量相互独立随机变量的和(标准化和)的分布近似为正态分布。

这里我们主要讨论中心极限定理的两种基本形式。

林德伯格-莱维(Lindeberg-Levy)中心极限定理

说法一:

设\(X_1,X_2,\cdots,X_n\)是一系列相互独立且同分布的随机变量,它们的期望和方差分别为\(\mu,\sigma^2\), 则\(Y_{n}=\frac{\sum_{i=1}^{n} X_{i}-n \mu}{\sigma \sqrt{n}}=\frac{\sum_{i=1}^{n} X_{i}-E\left(\sum_{i=1}^{n} X_{i}\right)}{\sqrt{D\left(\sum_{i=1}^{n} X_{i}\right)}}=\frac{X-E(X)}{\sqrt{D(X)}}\)的分布当\(n\rightarrow\infty\)时趋于正态分布(其中令\(X=\sum_{i=1}^{n} X_{i}\)), 即对任意实数x,有\(P(Y_n\leqslant x)= P\left(\frac{\sum_{i=1}^{n} X_{i}-n \mu}{\sigma \sqrt{n}} \leqslant x\right)=P\left(\frac{X-E(X)}{\sqrt{D(X)}}\leqslant x\right) \rightarrow \Phi(x)=\frac{1}{\sqrt{2 \pi}} \int_{-\infty}^{x} \mathrm{e}^{-\frac{x^{2}}{2}} \mathrm{~d} x, \quad n \rightarrow \infty\)

说法二:

设随机变量 \(X_{1}, X_{2}, \cdots, X_{n}\) 独立同分布, \(D\left(X_{i}\right)=\sigma^{2} \neq 0(i=1,2, \cdots, n)\) \(\bar{X}=\frac{1}{n} \sum_{i=1}^{n} X_{i}, \zeta_{n}=\frac{\bar{X}-\mu}{\sigma / \sqrt{n}},\) 则 \(\lim _{n \rightarrow \infty} P\left(\zeta_{n} \leq z\right)=\Phi(z)\) 其中 \(\Phi(z)\) 是标准正态分布的分布函数。

证明 记 \(X_{k}-\mu\) 的特征函数为 \(\varphi(t),\) 根据傅里叶变换样本空间中的褶积(卷积)在特征函数空间变为乘积, 因此 \(\zeta_{n}\) 的特征函数为 \(\left[\varphi\left(\frac{t}{\sigma \sqrt{n}}\right)\right]^{n}\).由于 \(E\left(X_{k}\right)=\mu, D\left(X_{k}\right)=\sigma^{2}\) 故 \(\varphi^{\prime}(0)=0, \varphi^{\prime \prime}(0)=-\sigma^{2}\).因此 \(\varphi(t)=1-\frac{1}{2} \sigma^{2} t^{2}+o\left(t^{2}\right)\) 所以 \[ \left[\varphi\left(\frac{t}{\sigma \sqrt{n}}\right)\right]^{n}=\left[1-\frac{1}{2 n} t^{2}+o\left(\frac{t^{2}}{n}\right)\right]^{n} \rightarrow e^{-t^{2} / 2} \] 由于 \(e^{-t^{2} / 2}\) 是连续函数, 它对应的分布函数为 \(\Phi(Z),\) 因此由逆极限定理知 \[ \lim _{n \rightarrow \infty} P\left(\zeta_{n} \leq z\right) \rightarrow \Phi(z) \] 定理证毕。

棣莫弗-拉普拉斯(De Moivre-Laplace)中心极限定理

该中心极限定理是历史上最早的中心极限定理。

表述一:

设随机变量\(X_1,X_2,\cdots\)相互独立且都服从参数为 p(0<p<1) 的0-1分布, 则对任意实数x,有\(\lim _{n \rightarrow \infty} P\left(\frac{\sum_{i=1}^{n} X_{i}-n p}{\sqrt{n p(1-p)}} \leqslant x\right)=\Phi(x)\)

表述二:(很明显有\(\sum_{i=1}^{n} X_{i} \sim B(n, p)\))

设随机变量\(Y_n = \sum_{i=1}^{n} X_{i} \sim B(n, p)\), 则对任意实数x,有\(\lim _{n \rightarrow \infty} P\left(\frac{Y_{n}-n p}{\sqrt{n p(1-p)}} \leqslant x\right)=\Phi(x)\)

表述三:

若 \(X \sim B(n, p)\) 是 \(n\) 次伯努利实验中事件 \(A\) 出现的次数, 每次试验成功的概率为 \(p,\) 且 \(q=1-p,\) 则对任意有限 区间 \([a, b]:\) \(\hat{\text { 令 }} x_{k} \equiv \frac{k-n p}{\sqrt{n p q}},\) 当 \(n \rightarrow \infty\) 时 (i) \(P(X=k) \rightarrow \frac{1}{\sqrt{n p q}} \cdot \frac{1}{\sqrt{2 \pi}} e^{-\frac{1}{2} x_{\mu_{n}}^{2}}\) (ii) \(P\left(a \leq \frac{X-n p}{\sqrt{n p q}} \leq b\right) \rightarrow \int_{a}^{b} \varphi(x) d x,\) 其中 \(\varphi(x)=\frac{1}{\sqrt{2 \pi}} e^{-\frac{x^{2}}{2}}(-\infty<x<\infty)\)

该中心极限定理表明,正态分布是二项分布的极限分布。即当n充分大时,可用正态分布近似计算二项分布的概率。它指出,参数为n, p的二项分布以np为均值、np(1-p)为方差的正态分布为极限。